近年来,人工智能(AI)已成为全球科技发展的核心驱动力,其应用从医疗诊断到自动驾驶,再到个性化推荐系统,无处不在。随着技术的快速迭代和市场泡沫论的兴起,许多从业者和观察者开始质疑:人工智能还能‘撑’多久?这一问题的答案,不仅仅取决于技术突破的速度,还与基础软件开发的成熟度息息相关。

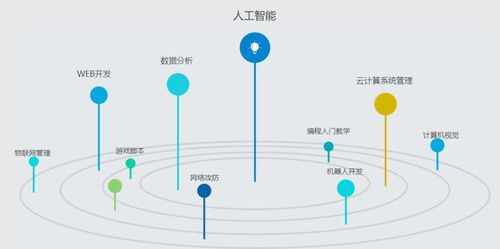

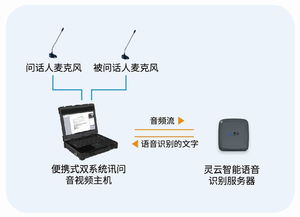

从技术生命周期来看,人工智能远未达到饱和点。尽管深度学习模型在图像识别、自然语言处理等领域取得了显著成就,但通用人工智能(AGI)——即能够像人类一样全面理解和应对复杂环境的系统——仍是一个遥远的梦想。当前,AI的发展更多依赖于数据驱动和算力提升,而基础软件正是连接硬件能力与上层应用的桥梁。例如,TensorFlow、PyTorch等开源框架的普及,极大地降低了AI模型的开发门槛,但它们在可解释性、能耗优化和跨平台兼容性方面仍存在不足。如果基础软件不能跟上硬件创新(如量子计算或神经形态芯片)的步伐,AI的发展可能遭遇瓶颈。

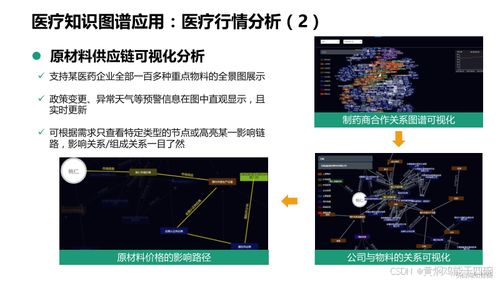

基础软件开发的可持续性是关键制约因素。AI系统依赖于高质量的软件栈,包括数据处理工具、模型训练平台和部署环境。许多现有软件存在碎片化问题:不同框架之间的兼容性差,导致模型迁移成本高;安全漏洞和隐私风险频发,如数据泄露或模型被恶意攻击;软件开发人才短缺,尤其是精通AI算法和系统工程的复合型人才供不应求。这些问题若得不到解决,可能延缓AI的普及速度。例如,在自动驾驶领域,软件错误可能导致致命事故,这凸显了基础软件可靠性的重要性。

经济和社会因素也影响AI的‘续航’能力。投资泡沫可能导致资源浪费,但市场需求(如企业数字化和智能家居)仍在增长。基础软件的优化可以降低AI应用的运营成本,例如通过自动化模型调参或边缘计算部署,这将延长AI的生命周期。同时,伦理和监管问题(如AI偏见和算法透明度)要求软件开发必须融入合规设计,否则可能引发公众信任危机。

人工智能的可持续发展离不开基础软件的创新。业界需要推动标准化工作,如统一接口协议和开源生态建设;加强跨学科合作,将软件工程与AI研究深度融合;并关注绿色计算,减少AI的碳足迹。AI不会在短期内‘倒下’,但它能否长期繁荣,取决于我们如何夯实基础软件这一根基。只有通过持续迭代和全局优化,人工智能才能从‘热门趋势’蜕变为真正改变世界的持久力量。